Definition

Adversarial Examples sind manipulierte Daten, die absichtlich dazu entworfen wurden, dass sie maschinelle Lernsysteme täuschen und zu falschen Vorhersagen führen. Diese Manipulationen werden normalerweise nur auf den Input angewendet und sind für Menschen oft nicht wahrnehmbar. Sie stellen eine Sicherheitslücke für maschinelle Lernmodelle dar und haben in den letzten Jahren große Aufmerksamkeit erregt.

Idee dieser Daten

Die Idee basiert auf der Ausnutzung der Schwächen von neuronalen Netzwerken. Diese Netzwerke basieren auf der Verwendung von mathematischen Funktionen, um Muster und Zusammenhänge in den Trainingsdaten zu erkennen. Adversarial Examples nutzen gezielt die Nichtlinearität dieser Funktionen aus, um kleine, imperzeptive Störungen zu erzeugen, die jedoch große Auswirkungen auf die Vorhersagen des Modells haben.

Beispiel

Ein bekanntes Beispiel für Adversarial Examples ist das „Fast Gradient Sign Method“ (FGSM). Dabei wird der Gradient der Kostenfunktion bezüglich der Eingabe berechnet und anschließend wird das Eingabebild in Richtung des Gradienten angepasst. Das resultierende Bild führt dazu, dass das neuronale Netzwerk eine falsche Vorhersage trifft. Diese Methode kann auf verschiedene neuronale Netzwerkarchitekturen angewendet werden und ist vergleichsweise einfach zu implementieren.

Auswirkungen

Adversarial Examples haben sowohl theoretische als auch praktische Auswirkungen. Theoretisch werfen sie Fragen zur Robustheit und Verlässlichkeit von maschinellen Lernmodellen auf. Wenn kleine Störungen in den Eingabedaten zu großen Fehlern führen können, kann das Vertrauen in diese Modelle erheblich erschüttert werden. Praktisch betrachtet können sie verwendet werden, um Bilderkennungssysteme zu täuschen, Sicherheitsmechanismen zu umgehen oder Spamfilter zu überlisten.

Ansätze

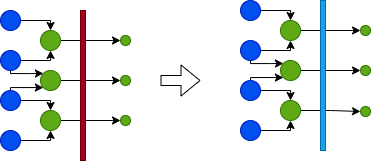

Es gibt verschiedene Ansätze, um mit Adversarial Examples umzugehen. Ein Ansatz besteht darin, robustere neuronale Netzwerkarchitekturen zu entwickeln, die weniger anfällig für solche Angriffe sind. Dies kann durch den Einsatz von Verteidigungstechniken wie adversarial training oder dem Hinzufügen von Rauschen zu den Eingabedaten erreicht werden.

Ein anderer Ansatz ist die Entwicklung von Gegenmaßnahmen auf der Seite der Entwickler. Hierbei werden Methoden entwickelt, um Adversarial Examples zu erkennen und zu filtern, bevor sie das System beeinflussen können. Dies kann durch die Verwendung von speziellen Algorithmen oder die Integration von externen Services erreicht werden.

Fazit

Die Erforschung von Adversarial Examples und deren Gegenmaßnahmen ist ein aktiver Bereich der Forschung im Bereich des maschinellen Lernens. Es werden kontinuierlich neue Methoden entwickelt, um diese Sicherheitslücke zu schließen und die Robustheit von maschinellen Lernmodellen zu verbessern. Diese Daten haben gezeigt, dass maschinelles Lernen nicht nur eine Frage der Genauigkeit und Leistung ist, sondern auch der Sicherheit und Zuverlässigkeit.