Was ist Bias?

Der Begriff Bias bezieht sich auf eine systematische Verzerrung oder Vorurteil, die in den Entscheidungen oder Ergebnissen von KI-Systemen auftreten kann. Diese Verzerrungen können verschiedene Formen annehmen und haben das Potenzial, Vorurteile und Ungleichheiten in der KI-Anwendung zu verstärken. Es ist von großer Bedeutung, sich der möglichen Auswirkungen von Bias in KI-Systemen bewusst zu sein und Mechanismen zu entwickeln, um sie zu minimieren.

Auswirkungen von Voreingenommenheit in KI-Systemen

Bias kann verschiedene Auswirkungen haben, insbesondere wenn es um Entscheidungsfindung und Vorhersagen geht. Hier sind einige Beispiele für die potenziellen Auswirkungen von Bias in KI-Systemen:

-

Diskriminierung

KI-Systeme können aufgrund von Bias zu diskriminierenden Entscheidungen führen. Beispielsweise könnten Bewerbungsverfahren oder Kreditwürdigkeitsprüfungen aufgrund von ungleichen Behandlungen bestimmter Bevölkerungsgruppen benachteiligt werden.

-

Ungleichheiten verstärken

Wenn KI-Systeme auf Daten trainiert werden, die bereits vorhandene Ungleichheiten widerspiegeln, können sie diese Ungleichheiten verstärken. Zum Beispiel könnten KI-gesteuerte Personalentscheidungen bestehende Geschlechterungleichheiten in Unternehmen verfestigen.

-

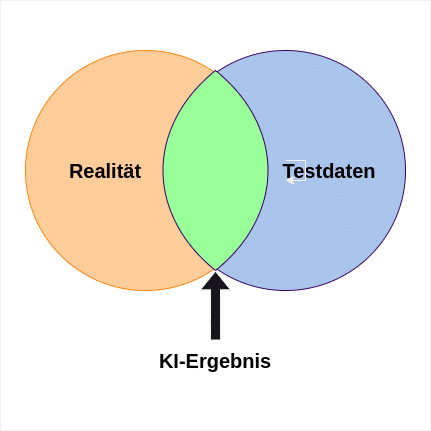

Fehlende Repräsentativität

Wenn die Trainingsdaten für KI-Systeme nicht ausreichend repräsentativ sind, kann dies zu einer Verzerrung der Ergebnisse führen. Wenn bestimmte Bevölkerungsgruppen unterrepräsentiert sind, kann die KI möglicherweise nicht genaue Vorhersagen für diese Gruppen treffen.

-

Verzerrte Empfehlungen

KI-gesteuerte Empfehlungssysteme können dazu neigen, nur bestimmte Arten von Inhalten oder Produkten zu fördern, basierend auf den Vorlieben der Benutzer. Dadurch könnten Benutzer in Filterblasen gefangen bleiben oder auf stereotype oder radikale Inhalte gelenkt werden.

Minimierung der Voreingenommenheit und ethische Implikationen

Es ist von entscheidender Bedeutung, Mechanismen zu entwickeln, um Bias in KI-Systemen zu minimieren. Hier sind einige Ansätze, die dazu beitragen können:

-

Datenqualität verbessern

Eine sorgfältige Überprüfung und Bereinigung der Trainingsdaten kann helfen, verzerrte Ergebnisse zu minimieren. Die Daten sollten so vielfältig und repräsentativ wie möglich sein.

-

Algorithmische Transparenz

Es ist wichtig, dass die Funktionsweise von KI-Systemen transparent und nachvollziehbar ist. Dies ermöglicht es, Bias zu identifizieren und zu korrigieren.

-

Diversität bei der Entwicklung

Die Teams, die KI-Systeme entwickeln, sollten divers zusammengesetzt sein, um verschiedene Perspektiven und Erfahrungen einzubringen und mögliche Bias-Quellen zu identifizieren.

-

Regulierung und Standards

Die Einführung von Regulierungen und Standards kann dazu beitragen, die Verantwortlichkeit der KI-Entwickler zu stärken und sicherzustellen, dass ethische und faire Praktiken eingehalten werden.

Fazit

Bias in KI-Systemen ist ein wichtiges Thema, das sorgfältige Aufmerksamkeit erfordert. Es ist unerlässlich, dass KI-Systeme so entwickelt und trainiert werden, dass sie frei von Vorurteilen und Verzerrungen sind. Durch den Einsatz von transparenten und diversen Ansätzen können wir sicherstellen, dass KI-Systeme ethisch und gerecht sind und eine positive Wirkung auf die Gesellschaft haben.