Definition

Recurrent Neural Networks (RNNs) sind eine spezielle Klasse von künstlichen neuronalen Netzwerken, die entwickelt wurden, um sequenzielle Daten effektiv zu verarbeiten. Im Gegensatz zu herkömmlichen Feedforward-Netzwerken können RNNs Informationen über vorherige Zustände speichern, was sie besonders gut für die Verarbeitung von Zeitreihen, Sprachdaten und anderen sequenziellen Informationen geeignet macht. Die Fähigkeit, Kontextinformationen über vorherige Ereignisse zu bewahren, verleiht RNNs eine einzigartige Stärke bei der Modellierung dynamischer und kontextabhängiger Muster.

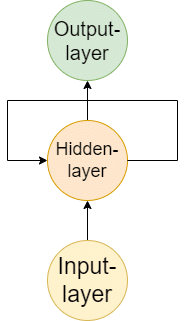

Funktionsweise

Der grundlegende Baustein eines RNNs ist die rekurrente Schleife, die es dem Netzwerk ermöglicht, Informationen von einem Zeitschritt zum nächsten zu übertragen. Bei jedem Zeitschritt nimmt das RNN eine Eingabe entgegen und gibt eine Ausgabe aus, die wiederum als Eingabe für den nächsten Zeitschritt dient. Gleichzeitig werden die Informationen des vorherigen Zustands im Netzwerk gespeichert und fließen in den aktuellen Berechnungsprozess ein.

Anwendungen

Recurrent Neural Networks finden in verschiedenen Bereichen Anwendung:

-

Sprachmodellierung

RNNs können zur Erzeugung von Text verwendet werden, da sie Kontextinformationen über vorherige Wörter bewahren und somit realistische Texte generieren können.

-

Maschinelles Übersetzen

In der Übersetzung können RNNs Sequenzen von Wörtern in einer Sprache auf Sequenzen in einer anderen Sprache abbilden.

-

Sentiment-Analyse

RNNs können verwendet werden, um die Stimmung in Texten zu erkennen, indem sie die Abfolge von Wörtern analysieren.

-

Spracherkennung

RNNs sind auch in der Spracherkennung nützlich, da sie Audiodaten in Text umwandeln können, indem sie die zeitliche Abfolge von Audiosignalen analysieren.

Herausforderungen

Obwohl RNNs sehr leistungsfähig sind, haben sie auch einige Herausforderungen. Ein bekanntes Problem ist das Verschwinden oder Explodieren des Gradienten, das während des Trainings auftreten kann, wenn die rekurrenten Schleifen über viele Zeitschritte hinweg ausgeführt werden. Dies führt dazu, dass die Gewichte entweder sehr klein werden und das Netzwerk nicht lernen kann (Verschwinden des Gradienten) oder dass die Gewichte extrem groß werden und das Netzwerk instabil wird (Explodieren des Gradienten). Dieses Problem kann durch die Verwendung von Long Short-Term Memory (LSTM) oder Gated Recurrent Unit (GRU) gelöst werden, die spezielle Architekturen von RNNs sind und das Problem des verschwindenden oder explodierenden Gradienten mildern.

Fazit

Recurrent Neural Networks sind eine leistungsfähige Art von neuronalen Netzwerken, die sich besonders gut für die Verarbeitung von sequenziellen Daten eignen. Durch die Fähigkeit, Kontextinformationen über vorherige Ereignisse zu bewahren, haben RNNs breite Anwendungen in Bereichen wie Sprachmodellierung, maschinellem Übersetzen, Sentiment-Analyse und Spracherkennung gefunden. Mit der Weiterentwicklung von Architekturen wie LSTM und GRU wurde auch das Problem des verschwindenden oder explodierenden Gradienten erfolgreich adressiert, was die Anwendung von RNNs weiter verbessert hat.