Definition

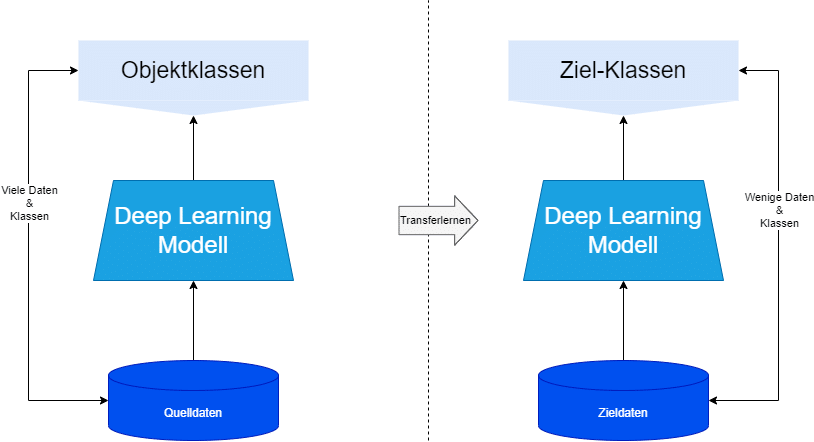

Das Transferlernen ist ein bedeutendes Konzept in der künstlichen Intelligenz und maschinellen Lernens, das es ermöglicht, Wissen, das in einer bestimmten Aufgabe gelernt wurde, auf andere, verwandte Aufgaben anzuwenden. Dabei geht es darum, Erfahrungen und Kenntnisse, die in einem bestimmten Kontext gesammelt wurden, auf neue, ähnliche oder sogar unterschiedliche Kontexte zu übertragen und so die Leistungsfähigkeit von Modellen zu verbessern.

Grundprinzipien des Transferlernens

-

-

Quellaufgabe und Zielaufgabe

Beim Transferlernen gibt es in der Regel zwei Aufgaben – die Quellaufgabe (source task) und die Zielaufgabe (target task). In der Quellaufgabe wird das Modell trainiert, während es in der Zielaufgabe eingesetzt wird, um eine andere, verwandte oder sogar komplett neue Aufgabe zu lösen.

-

-

-

Ähnlichkeit der Aufgaben

Der Erfolg des Transferlernens hängt davon ab, wie ähnlich sich die Quell- und Zielaufgaben sind. Eine höhere Ähnlichkeit erleichtert die Übertragung von Wissen, da das Modell bereits relevante Konzepte oder Merkmale in der Quellaufgabe gelernt hat, die in der Zielaufgabe von Nutzen sein können.

-

-

Repräsentationen lernen

Im Transferlernen geht es darum, allgemeine und wiederverwendbare Repräsentationen zu lernen, die über die spezifische Quellaufgabe hinausgehen. Diese Repräsentationen sollten relevante Informationen extrahieren, die auf verschiedene Kontexte angewendet werden können.

Arten des Transferlernens

-

-

Induktives Lernen

Hier wird Wissen von einer Quellaufgabe auf eine neue Zielaufgabe übertragen, wobei die zugrunde liegenden Merkmale und Konzepte ähnlich sind. Beispielsweise kann ein Modell, das Bilder von Hunden und Katzen unterscheidet, auf eine neue Aufgabe angewendet werden, um andere Tierarten zu klassifizieren.

-

-

-

Transdisziplinäres Lernen

Diese Form des Transferlernens bezieht sich auf die Übertragung von Wissen zwischen verschiedenen Disziplinen. Informationen und Modelle aus einem bestimmten Bereich können auf eine völlig andere Domäne angewendet werden, um Lösungen zu verbessern. Ein Beispiel dafür wäre die Anwendung von Textübersetzungstechniken auf musikalische Kompositionen.

-

-

Multitask-Lernen

Beim Multitask-Lernen wird ein Modell auf mehreren Aufgaben gleichzeitig trainiert, um von den Wechselwirkungen zwischen den Aufgaben zu profitieren und so die Gesamtleistung zu steigern.

Vorteile des Transferlernens

-

-

Effizienz

Transferlernen reduziert den Bedarf an großen Mengen an Trainingsdaten für neue Aufgaben, da das Modell bereits auf ähnliche Aufgaben vortrainiert wurde.

-

-

-

Generalisierung

Modelle, die Transferlernen nutzen, haben oft eine bessere Fähigkeit zur Generalisierung und sind robuster gegenüber Änderungen in den Eingabedaten.

-

-

Zeit- und Ressourceneinsparung

Da das Modell bereits vortrainiert wurde, kann die Trainingszeit für neue Aufgaben verkürzt werden.

Herausforderungen im Transferlernen

-

-

Negativer Transfer

Es besteht die Möglichkeit, dass Informationen aus der Quellaufgabe das Modell in der Zielaufgabe stören, wenn sich die Aufgaben zu stark unterscheiden.

-

-

-

Domänenunterschiede

Wenn die Quell- und Zielaufgaben aus unterschiedlichen Domänen stammen, können Domänenunterschiede das Transferlernen erschweren.

-

-

Wahl der Quellaufgabe

Die Auswahl einer geeigneten Quellaufgabe ist entscheidend, da nicht alle Aufgaben gleichermaßen von der Übertragung profitieren.

Fazit

Insgesamt bietet das Transferlernen eine leistungsstarke Methode, um die Effizienz und Wirksamkeit von maschinellen Lernmodellen zu steigern und den Fortschritt in der künstlichen Intelligenz voranzutreiben.